지난 주말에는 Hash Tag 분석에 대한 참으로 흥미로운 책 한 권을 우연히 읽게 되었습니다. 저자인 Kevin Hillstrom 역시 저처럼 데이터베이스 마케팅, CRM 분석 쪽에서 경력을 쌓다 소셜 데이터의 흥미로움에 끌려 소셜 분석 쪽에 발을 담궜더군요.

특히, CRM 의 다양한 분석 기법을 소셜데이터에 적용하는 실험을 하고 실제로 의미있는 인사이트를 얻고 있었습니다.

저자는 소셜미디어 내의 특정 커뮤니티 내에서 한 명의 영향력 자를 마케터가 파악하게 되면 그 영향력자를 통해 커뮤니티의 방향성을 어느 정도 조작 가능하다는 접근에 대해 의문을 품게 되었습니다. 즉, 한 명의 영향력자의 힘에 대해 지나치게 강조하고 있다는 것이지요.

하여 저자는 Mack Collier 라는 영향력자가 주최하는 #blogchat 이라는 소셜미디어 커뮤니티를 실험 대상으로 삼아 #blogchat 과 관련된 대화 데이터를 4개월 간 수집합니다.

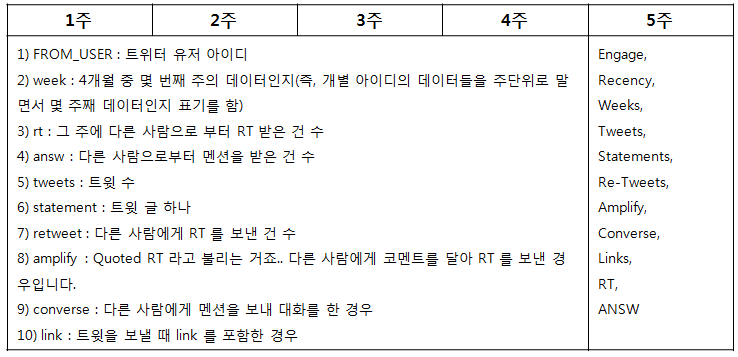

분석에 사용된 데이터를 살펴보면 아래와 같습니다.

1) FROM_USER : 트위터 유저 아이디

2) week : 4개월 중 몇 번째 주의 데이터인지(즉, 개별 아이디의 데이터들을 주단위로 말면서 몇 주째 데이터인지 표기를 함)

3) rt : 그 주에 다른 사람으로 부터 RT 받은 건 수

4) answ : 다른 사람으로부터 멘션을 받은 건 수

5) tweets : 트윗 수

6) statement : 트윗 글 하나

7) retweet : 다른 사람에게 RT 를 보낸 건 수

8) amplify : Quoted RT 라고 불리는 거죠.. 다른 사람에게 코멘트를 달아 RT 를 보낸 경우입니다.

9) converse : 다른 사람에게 멘션을 보내 대화를 한 경우

10) link : 트윗을 보낼 때 link 를 포함한 경우

이 Raw Data 를 기반으로 매 4주마다 데이터를 점검해서, 데이터마트를 구축합니다.

매 5주 차에 생성되는 이 데이터 마트에는 3개의 새로운 변수가 추가됩니다.

첫번째 새로운 변수는 Engage 라는 변수로, 5주째에 최소 1개 이상의 트윗을 #blogchat 으로 보냈을 때는 1, 아닐 경우는 0 으로 코딩을 해 줍니다.

다음으로 두번째 새로운 변수인 Recency 값을 기록해 줍니다. Recency (최신성)는 “weeks since last participation”으로 정의되는데, 마지막으로 활동에 참여한 것이 몇 주 전인지 기록합니다. 예를들어, 트위터 유저가 1주일 전에 마지막으로 #blogchat 에 참여했을 경우에는 1, #blogchat 에 마지막으로 참여한 게 4주 전일 경우 4를 기록합니다. 즉, 가장 최근까지 활동했을 경우 값이 1되고, 최근 활동이 미흡할 경우 값이 4가 됩니다. 값은 4주간의 기록이므로 1,2,3,4 중 한 개의 값을 가집니다.

세번째 새로운 변수는 Weeks 입니다. Weeks 에는 지난 4주 동안의 참여한 주의 개수를 기록합니다. Recency 와 마찬가지로 1, 2, 3, 4의 값을 가지며, 4주에 걸쳐 매주 활동에 참여했을 경우 4, 4주 중 한 주에만 활동에 참여했을 경우 1을 기록합니다.

나머지 변수들 중 Tweets, Statements, Re-Tweets, Amplify, Converse, Links 에는 지난 4주 동안의 활동 값의 평균값을 기록하고 RT, ANSW 변수에는 지난 4주동안 한 번이라도 RT(Mention)을 받았을 때는 1, 0 값을 기록합니다.

즉, 4주가 지나고 매 5주차마다 아래와 같이 데이터 마트를 생성하는 것입니다.

위와 같은 방식으로 데이터 마트를 구성하고 나면, 데이터를 또 다방면으로 들여다 볼 수 있게 됩니다.

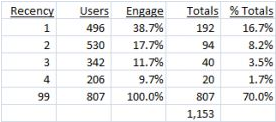

예를 들어 데이터들을 recency 기준으로 다시 들여다 보면 아래와 같은 데이터 셋을 얻을 수 있고, 또 재미있는 발견을 할 수 있습니다.

유저가 마지막으로 활동에 참여한 주가 1주 전인 경우와 4주 전인 경우를 대비했을 때 마지막 활동 참여 주가 가장 최근인 1주일 경우에는 Engage 율(#blogchat 해쉬 태그로 적어도 1회 아싱 트윗을 날린 비율)이 높은 반면 4주로 갈 수록 Engage 율이 낮아지는 거죠… 어찌생각하면 가장 최근까지 활동한 사람일 수록 활동도 왕성하다는 건 당연하지만, 이렇게 데이터로 확실하게 검증을 한다는 게 의미가 있을 듯 합니다.

또한, 유저의 활동이 뜸해지지 않도록 관리를 해 줘야 할 필요성도 이 데이터를 통해 확인할 수 있습니다. 1주, 2주, 활동이 뜸해 질 수록 미래 engage 율도 떨어지니까요..

이렇게 데이터를 drill down 하면 할 수록 흥미진진한 발견을 많이 할 수 있습니다.

Recency 변수와 Weeks 변수를 연동 분석하면, 최신성이 높고(1에 가까울수록), 활동주수가 많을 수록(4에 가까울수록) 이용자들의 engagement rate 가 높아진다는 것을, 커뮤니티 뉴 멤버들의 트윗수와 Engagement rate 데이터를 들여다 보면, 트윗을 한 건 날린 유저들보다 2번 이상 날린 유저들의 engagement rate 가 훨씬 높다는 것을 알 수 있습니다. (Rule of Two가 여기도 적용되네요.. 첫 구매 구객을 어떻게든 재구매하게 만들라.. 두번째 구매부터는 재구매율이 더 높아지리라.. 라는 규칙..)

음.. 이야기가 너무 깊이 들어가고, 어려워 지는 느낌이 없지 않아 있지만, 아래 분석 내용 역시 공유를 안할 수 없을 듯 합니다.

위 그래프가 의미하는 바는 너무도 명확한 듯 합니다. 4주동안 다른 사람 글을 RT를 해 줬는데, 자기는 아무런 mention 도 받지 않은 사람이 그 다음 5주 째에 글 한 줄이라도 올릴 확률은 6%인데, 다른 사람 글을 RT 를 해 줬는데 반응이 왔을 경우 그 다음 주 커뮤니티에 또 참여할 확률은 61.9%라는 것이지요…

아.. 트위터 공간에서 RT와 Mention 으로 다른 사람에게 화답하는 것이 얼마나 중요한지 다시 한번 느끼게 되는 순간입니다.

저자는 또한, 이렇게 구축된 데이터마트로 고객 Segmentation 기법을 설명하고, 개별 Seg 별 Engagement rate 도 살펴 보고 있습니다.

이렇게 고객 Segment 를 나눠 개별 Seg 특성을 기술하고, 시간의 변화에 따라 한 명의 개인이 어떤 Seg 에서 어떤 Seg 로 움직여 가는지, 시간의 흐름에 따라 Seg 비중이 바뀜에 따라 커뮤니티의 흥망성쇄가 어떻게 변화되는지 살펴봄으로써, 커뮤니티가 더 성장할 것인지 쇠퇴할 것인지까지 예측이 가능하지요.

자사에 옹호적인 고객 층을 키워나가는 마케팅 전략 수립을 위해 고객 프로필 분석을 주기적으로 하는 것 역시 소셜 데이터 분석의 중요한 흐름 중 하나가 될 것으로 생각했었는데, 마침 좋은 예시가 될 수 있을 듯 해 공유드립니다.

아.. 저도 이런 데이터 분석하고 싶은데.. 돈 벌기 용 플젝때문에 바쁘다는 핑계를 대고 R&D를 소홀히 하고 있네요..쩝..

혹시 자사 브랜드로 온라인 고객 Engagement Rate 분석해서, 이 Engagement Rate 랑 자사 매출 데이터랑 상관분석해 보실 기업없으신가요? 혹시 의향이 있으시면 (Twitter-@ottugui)에게로 언제든 연락주세용~~

소셜데이터 수집부터 데이터 마이닝까지 든든하게 지원해줄 개발사와 함께 제안들어갑니다.. 고고씽~~

2 Comments